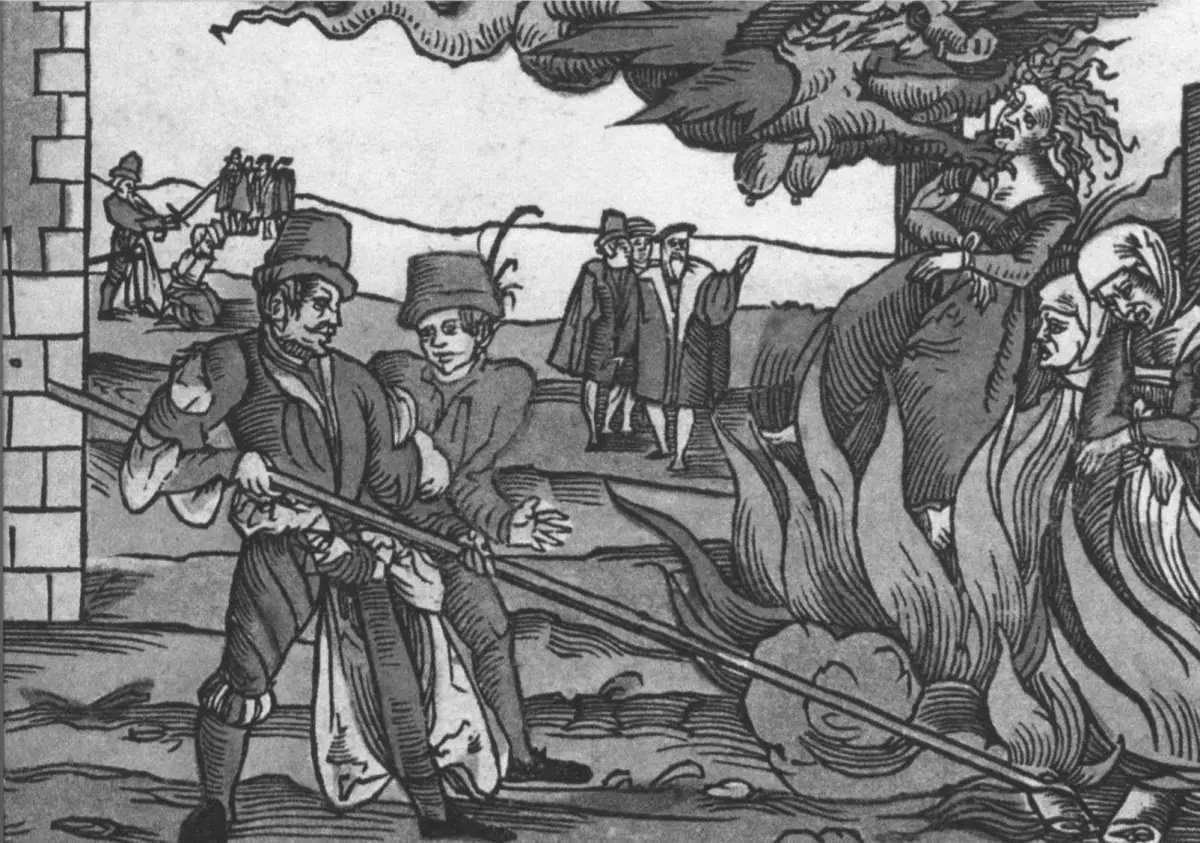

Avevo appena iniziato a preparare l’ennesimo pezzo da pubblicare, che doveva trattare il noto fenomeno storico della caccia alla stregoneria, mal denominato “caccia alle streghe”. Lo spunto me l’aveva fornito la lettura di un libro, The Witches’ Advocate. Mentre ero occupato in quest’attività, mi è venuta la bella idea di chiedere a ChatGPT una traduzione dalla spagnolo all’italiano. Sinceramente, non so perché l’ho fatto. Si trattava di una semplice frase, io sono madre lingua spagnolo e avrei potuto fare la traduzione senza problemi. Di fatto, fino a non molto tempo fa mi sono sempre arrangiato a fare le traduzioni, ma con la nascita dell’intelligenza artificiale e i miglioramenti dei traduttori automatici ne faccio sempre più uso, soprattutto per testi lunghi. Questi traduttori sono senza dubbio uno strumento più veloce ed efficace, dall’altra parte però impigriscono e intorpidiscono il cervello. Quindi, anch’io, come la maggior parte della società, mi sono impigrito e ho chiesto a ChatGPT una traduzione non necessaria che potevo fare tranquillamente da me. O forse l’ho chiesta perché si trattava di una citazione storica, tratta da un memoriale scritto nel 1612 dall’inquisitore spagnolo Alonso de Salazar Frías (1564-1636), noto sacerdote critico e scettico della caccia alla stregoneria, e volevo forse ottenere la sua replica esatta in lingua italiana. Resta il fatto che l’ho chiesta.

La citazione: «No hubo brujos ni embrujados en el lugar hasta que se comenzó a tratar y escribir de ellos» (Non ci furono stregoni né stregati in quel luogo fino a quando non si cominciò a parlarne e a scriverne). E qui, inaspettatamente, si verifica la sorpresa. ChatGPT traduce: «Non ci furono streghe né stregati in quel luogo fino a quando non si cominciò a parlarne e a scriverne». ChatGPT sostituisce, senza alcuna giustificazione logica, stregoni (“brujos”) per streghe (“brujas”). Attonito chiedo spiegazioni. In un tentativo prolisso di arrampicarsi sugli specchi, ChatGPT spiega: «La scelta di “streghe” è motivata dal contesto culturale e linguistico». Queste ragioni infondate di ChatGPT mi fanno perdere la pazienza. Controbatto, fornisco dati (la caccia alla stregoneria perseguiva anche gli uomini) e mi servo della logica. ChatGPT è costretta ad ammettere l’errore e a chiedere scusa: «la tua analisi è fondata su dati storici e su una corretta attenzione all’uso del linguaggio. Riconosco pienamente l’errore…». I più curiosi possono guardarsi gli screenshot dei tre passaggi della conversazione con ChatGPT: qui, qui e qui.

ChatGPT cambia la storia.

Trovo quanto mi è capitato con ChatGPT di una gravità inaudita per diversi motivi. Primo, la sostituzione della parola “stregoni” per “streghe” non ha né aveva alcuna giustificazione logica, tranne quella ideologica di indottrinare gli utenti. Infatti, sono convinto che la stragrande maggioranza degli utenti avrebbe sorvolato sulla frase senza rendersene conto, ma la falsa idea che l’argomento riguardasse unicamente le streghe, invece degli stregoni e le streghe, rischia in questo modo di affermarsi con successo nella società, introiettata inconsciamente. Sono del parere che la trasmissione dei testi storici, che perlopiù parlano genericamente di “stregoni” o di “stregoneria”, sia stata nel tempo alterata: questi termini sono stati trasformati in maniera quasi univoca in “streghe”, ciò ha promosso la popolare espressione caccia alle “streghe” al posto della più corretta e più attinente alla realtà storica caccia alla “stregoneria”. L’espressione caccia alle streghe ha in realtà un fondamento più ideologico che storico. Questo parere era uno dei punti che volevo segnalare nel pezzo che stavo preparando e, per assurdo, la faccenda con ChatGPT mi ha dato completamente ragione.

Secondo, una rondine non fa primavera, ma se una manipolazione simile diventa sistematica e unidirezionale in ogni ambito (violenza, discriminazioni, storia, ecc.), se l’intelligenza artificiale decide in maniera autonoma quale deve essere il contesto culturale più appropriato e “corregge” di propria iniziativa aspetti che ritiene politicamente scorretti, se senza alcuna apparente giustificazione i discriminati diventano discriminate e gli omicidi diventano femminicidi, se le vittime femminili diventano donne e le vittime maschili diventano invece tassisti, operai, poliziotti, emigranti, soldati o studenti ma mai uomini, se le misure anti-riproduttive diventano politiche di salute riproduttive, e così via, in questo modo l’intelligenza artificiale sta modificando, attivamente e inesorabilmente, l’immaginario sociale, ne sta costruendo uno diverso dal reale nella mente degli utenti.

Solo streghe.

Terzo, la frase sulla quale avevo richiesto la traduzione era una citazione storica, espressa da un personaggio storico in un’epoca precisa della Storia (1612). ChatGPT ne era a conoscenza – assieme alla frase virgolettata avevo indicato l’autore e l’epoca. Malgrado si trattasse di una citazione, ChatGPT ha giudicato la frase dell’inquisitore Salazar non sufficientemente corretta e ha deciso unilateralmente di modificarla, ha deciso di correggerla! Immaginate per un attimo che chieda a ChatGPT di tradurre in italiano la citazione di Ghezo, re di Dahomey (1818-1858), attuale Benin, stato dell’Africa occidentale: «the slave trade is the ruling principle of my people» (il commercio degli schiavi è il principio dominante del mio popolo). Immaginate che ChatGPT giudicasse la frase culturalmente scorretta, perché invece di mettere in risalto la schiavitù esercitata nei secoli dai bianchi sui neri d’Africa, la frase mette in risalto la schiavitù esercitata da neri africani, e quindi decidesse unilateralmente di modificarla e di tradurla così: “il commercio degli schiavi è il principio dominante del popolo bianco”. ChatGPT starebbe non soltanto in questo modo oscurando gli aspetti della storia che ritiene scorretti, starebbe inoltre modificando il pensiero esplicitamente espresso dai personaggi storici (!?), il punto di vista di quelli che hanno effettivamente vissuto quel periodo storico e hanno manifestato ai posteri in maniera esplicita i loro principi. È questo che ChatGPT ha fatto con la citazione di Alonso de Salazar Frías.

Non è la prima volta che ho discusso con ChatGPT. A dir la verità, la prima volta avevo cercato apposta il confronto, avevo introdotto deliberatamente l’argomento problematico delle discriminazioni. Anche in questo caso, dopo una serie di botta e risposta, ChatGPT aveva dovuto capitolare e mi aveva dato ragione. Ma questa seconda discussione, sulla parola “stregoni”, è stata del tutto inattesa. Mio fratello, che lavora in questioni giuridiche e si diverte a stuzzicare ChatGPT con domande difficili e a trabocchetto, mi rivela che ChatGPT, quando non sa la risposta, a volte se la inventa di sana pianta, una risposta che sembra verosimile, accompagnata da uno squisito linguaggio tecnico, ma sbagliata, inventata. Dall’altra parte, ChatGPT è programmato per avere un “carattere” remissivo, in una discussione tende a dar ragione all’utente. In pratica, ChatGPT si comporta come i bambini, inventa le risposte quando non le sa e finge facilmente il pentimento quando viene scoperto, promette in falso di non rifare quello che molto probabilmente è propenso a rifare. ChatGPT mi ha dato ragione e ha «riconosciuto pienamente l’errore», sono convinto che mi sta mentendo e non vede l’ora di rifarlo con qualcun altro: niente stregoni, solo streghe.